在当前人工智能与大数据技术迅猛发展的背景下,智能决策系统已广泛应用于交通调度、金融风控、医疗诊断、智能制造等多个关键领域。这些系统通过数据驱动的方式,实现对复杂环境的感知、分析与响应,极大提升了决策效率与准确性。然而,随着系统复杂度的提升,多个目标之间相互冲突的问题日益凸显,成为制约智能决策系统性能优化的重要瓶颈。

传统的多目标优化方法通常依赖于加权求和或帕累托前沿分析,试图在不同目标间寻找平衡点。然而,这类方法在面对动态、不确定性强的真实场景时,往往难以适应快速变化的环境需求,且容易陷入局部最优解。更为严重的是,当目标之间存在根本性矛盾时(如安全性与效率、公平性与收益最大化),简单的数学折中可能牺牲关键价值原则,导致决策结果不可接受。

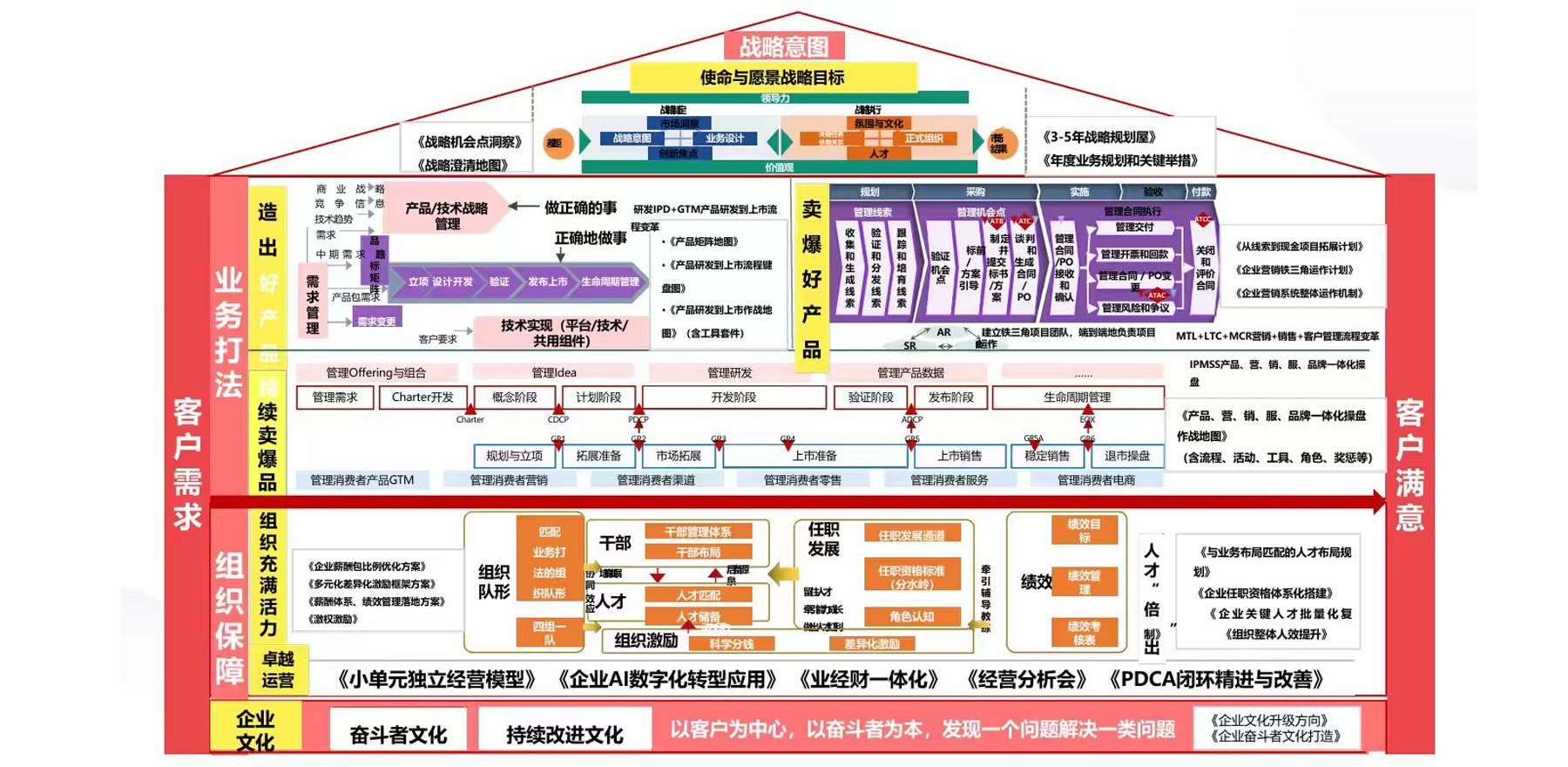

为突破这一困境,近年来学界与产业界开始探索更具适应性与解释性的目标冲突化解新思路。其中,基于价值对齐的分层决策架构正逐渐受到关注。该思路主张将抽象的“目标”还原为具体的“价值诉求”,并依据伦理优先级、社会规范和用户偏好构建分层结构。例如,在自动驾驶决策中,可将“生命安全”置于最高层级,其次为“交通效率”与“乘客舒适度”。系统在运行过程中,首先确保高层价值不被违背,再在满足前提下优化低层目标。这种结构不仅增强了决策的可解释性,也使系统更符合人类道德直觉。

另一种新兴路径是引入动态权重调节机制,借助强化学习与在线反馈实现目标权重的自适应演化。不同于静态赋权,该机制允许系统根据实时情境动态调整各目标的重要性。例如,在城市交通信号控制中,平峰时段可赋予通行效率更高权重,而在早晚高峰或突发事件期间,则自动提升应急车辆优先级与行人安全权重。通过持续学习环境反馈,系统能够在不同阶段灵活应对目标之间的张力,实现“情境感知型”协调。

此外,博弈论与多智能体协同框架也为解决目标冲突提供了新视角。在许多现实场景中,智能决策并非由单一主体完成,而是多个自治系统(如物流车队、电网节点、金融交易平台)共同参与的结果。此时,目标冲突本质上是利益相关方之间的策略博弈。通过构建合作博弈模型,引入激励相容机制与纳什均衡搜索算法,系统可在保障个体合理诉求的同时,推动整体效益最大化。例如,在能源调度系统中,不同发电单元可能追求各自利润,但通过设计合理的电价补偿机制,可引导其主动配合电网调峰需求,实现社会总成本最小化。

值得注意的是,化解目标冲突不能仅依赖技术手段,还需融入人文与制度维度。近年来,“可解释AI”(XAI)与“负责任AI”理念的兴起,强调决策过程应具备透明性、可追溯性与公众参与性。为此,一些研究提出建立人机协同仲裁机制:当系统检测到高度敏感的目标冲突时,自动触发人工介入流程,邀请领域专家或利益相关者参与评估与裁决。这种“人在回路”(human-in-the-loop)模式,既保留了机器的高效计算能力,又确保关键决策不失控于算法黑箱。

最后,未来智能决策系统的演进方向应是从“优化工具”向“价值协商平台”转型。这意味着系统不仅要能处理数据与规则,更要理解语境、识别价值冲突,并在多元目标间进行动态协商。例如,结合自然语言处理技术,系统可从政策文件、用户评论或社会舆论中提取隐含价值倾向,进而调整决策策略;利用因果推理模型,还可预判某项决策可能引发的连锁反应,提前规避潜在冲突。

综上所述,面对智能决策系统中日益复杂的目标冲突问题,亟需跳出传统优化范式,融合价值建模、动态学习、多主体协作与人文治理等多维思路。唯有如此,才能构建出既高效又可信、既智能又负责任的下一代决策支持系统,真正服务于可持续、包容性的社会发展目标。